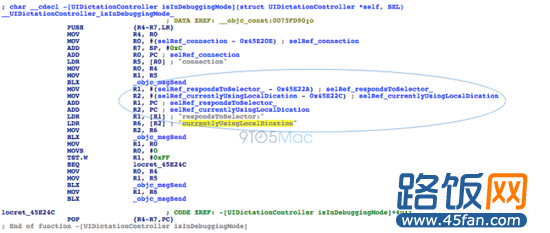

开发者哈姆扎·苏德(Hamza Sood)在iOS 7 beta中发现的一连串源代码显示,苹果正在iOS设备上测试一种本地离线版本的语音听写输入功能。相应的源代码出现在了两个版本的iOS 7 beta中,而且iOS 6中是没有的。目前,如果iOS用户想要使用听写功能实现语音输入文本,那么iOS设备必须使用软件将用户的语音上传至云端,并转化成文本。由于这个功能 依赖于互联网连接和云后端,因此有时候会出现错误和加载时间过长,以及意想不到的数据使用量。

基于苹果正在做的测试,iOS 7完整版或许使得iPhone、iPad或iPod Touch可以在本地将语音转化成文本。这将大大加快处理速度,通过语音操作的电子邮件、短信、笔记和网络搜索的速度会更加快。目前在对外的版本中,这个功能并没有被激活。但有消息称,苹果内部的版本正在运行这一功能。

还有消息称,这些测试版本中的本地听写功能是一种选择,先前基于云端的听写功能仍然会被保留。也许iOS系统的设置选项中可以选择这个功能是否进行互联网连接。

谷歌的Android操作系统就包含了离线听写功能。苹果一直将iOS定位为强于Android的系统,因此这个同等功能可能会让更多的用户转向iOS系统。苹果即将推出的OS X Mavericks系统通过下载几百兆的数据包,也可以支持这个功能。未来iOS系统支持这项功能似乎也要进行额外的下载。

虽然没有确实的证据,但似乎苹果会将这项技术逐步移植到Siri上。这会让Siri处理某些问题时可以加快速度。苹果最近两款带“S”的iPhone都包含语音技术的新元素。比方说,iPhone 3GS包含了语音控制,iPhone 4S上出现了Siri。也许iPhone 5之后的iPhone 5S会将本地听写作为独家卖点。本地语音处理是一个占用大量资源的过程,因此下一代iPhone的处理器和电池也要同步加强。

过去数周,好几个未公布的iOS 7功能被发现正在进行测试,包括新的手势选项和LinkedIn整合。和这些功能一样,现在还不确定iOS 7正式版本中是否会包含本地听写功能。

本文地址:http://www.45fan.com/a/luyou/2331.html